D

Devin

2026年1月26日

项目简介

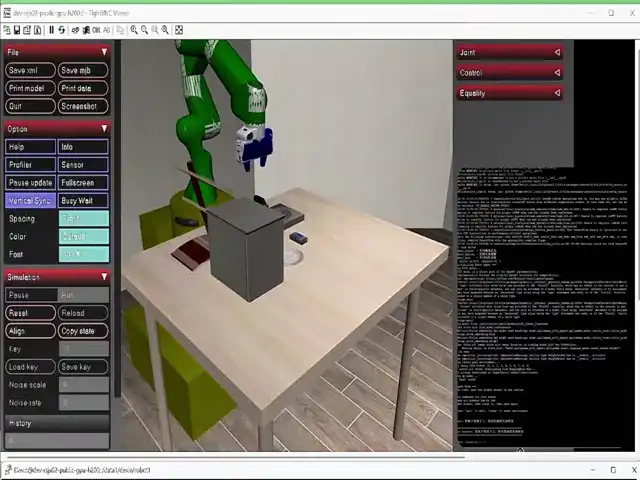

机器人 Agent 基于 MiniMax M2.1 文本模型和 Pi05 VLA(Vision-Language-Action)模型,在 LIBERO 仿真环境中实现自然语言驱动的机械臂操作。

MiniMax M2.1 任务规划

MiniMax M2.1 任务规划

理解用户的自然语言指令,将复杂任务分解为可执行的操作步骤,并协调多步骤任务的执行流程。

MiniMax MCP 视觉理解

MiniMax MCP 视觉理解

通过 MCP 调用视觉理解能力,分析场景图像,验证任务执行结果,实现闭环反馈控制。

Pi05 VLA 动作执行

Pi05 VLA 动作执行

基于 PaliGemma 的视觉-语言-动作模型,根据场景图像和任务指令,生成精确的机械臂控制动作。

LIBERO 仿真环境

LIBERO 仿真环境

在 MuJoCo 物理引擎驱动的仿真环境中,执行多种机器人操作任务。

系统架构

| 模块 | 技术方案 | 说明 |

|---|---|---|

| 任务规划 | MiniMax M2.1 | 理解用户意图,分解任务 |

| 视觉理解 | MiniMax MCP | 场景分析,结果验证 |

| 动作执行 | Pi05 VLA | 视觉-语言-动作模型 |

| 仿真环境 | LIBERO / MuJoCo | 机器人操作仿真 |

快速上手

安装依赖

| 依赖 | 说明 |

|---|---|

| LeRobot | HuggingFace 机器人学习库(已包含) |

| MuJoCo | DeepMind 物理仿真引擎 |

| LIBERO | 机器人操作仿真基准环境 |

| MCP | Model Context Protocol 客户端 |

支持的任务

在 LIBERO Goal 场景中,Agent 支持以下 10 个操作任务:| # | 任务指令 | 描述 |

|---|---|---|

| 1 | open the middle drawer of the cabinet | 打开橱柜中间抽屉 |

| 2 | put the bowl on the stove | 把碗放在炉子上 |

| 3 | put the wine bottle on top of the cabinet | 把红酒瓶放在橱柜上 |

| 4 | open the top drawer and put the bowl inside | 打开顶部抽屉把碗放进去 |

| 5 | put the bowl on top of the cabinet | 把碗放在橱柜上 |

| 6 | push the plate to the front of the stove | 把盘子推到炉子前面 |

| 7 | put the cream cheese in the bowl | 把奶油奶酪放进碗里 |

| 8 | turn on the stove | 打开炉子 |

| 9 | put the bowl on the plate | 把碗放在盘子上 |

| 10 | put the wine bottle on the rack | 把红酒瓶放在架子上 |

核心代码解析

Agent 工具定义

Agent 通过两个核心工具与环境交互:MiniMax M2.1 任务规划

使用 Anthropic 兼容接口调用 MiniMax M2.1:MCP 视觉理解

通过 MCP 调用 MiniMax 视觉理解能力验证任务结果:技术细节

Pi05 模型参数

| 参数 | 值 |

|---|---|

| 基础模型 | PaliGemma |

| 输入 | 2个相机图像 + 机械臂状态 + 语言指令 |

| 输出 | 7维动作(末端位置增量 + 姿态增量 + 夹爪) |

| 控制频率 | 10Hz |

| 最大步数 | 280步/任务 |

Agent 工作流程

- 用户输入:接收自然语言指令(中文或英文)

- 任务规划:MiniMax M2.1 理解意图,映射到支持的任务

- 动作执行:Pi05 VLA 生成机械臂控制序列

- 结果验证:MCP 视觉理解分析场景,确认任务完成

- 反馈循环:如验证失败,自动重试任务

常见问题

API 调用报错 'Invalid API Key'

API 调用报错 'Invalid API Key'

检查

ANTHROPIC_API_KEY 是否正确设置为 MiniMax 的 API Key。模型加载失败

模型加载失败

- 检查

HF_TOKEN是否配置 - 检查

MODEL_PATH路径是否正确

MCP 视觉理解报错

MCP 视觉理解报错

确保已安装:

pip install mcp 并且 uvx 命令可用。可视化窗口不显示

可视化窗口不显示

设置

export DISPLAY=:2(VNC)或确保有 X11 环境。应用拓展

基于当前架构,开发者可以考虑以下拓展方向:- 多任务串联:实现复杂任务的自动分解和顺序执行

- 失败恢复:增强 Agent 的错误检测和自动恢复能力

- 实物部署:将仿真中的策略迁移到真实机械臂

- 多模态交互:结合语音识别实现语音控制机器人

总结

在本教程中,我们展示了如何使用 MiniMax M2.1 和 MCP 视觉理解构建一个智能机器人 Agent:- MiniMax M2.1 负责理解用户意图,将自然语言指令转化为具体的操作任务

- MiniMax MCP 提供视觉理解能力,验证任务执行结果,实现闭环控制

- Pi05 VLA 作为底层执行器,根据视觉输入生成精确的机械臂动作

- LIBERO/MuJoCo 提供逼真的物理仿真环境